Programmierung und Training neuronaler Netze

Completion requirements

Modellarchitektur definieren:

- Die Struktur des neuronalen Netzes wird festgelegt, einschließlich der Anzahl der Schichten, der Anzahl der Neuronen in jeder Schicht und der Art der Aktivierungsfunktionen.

Gewichte initialisieren:

- Die Gewichte und Biases werden initial zufällig oder mit speziellen Techniken wie Xavier- oder He-Normal-Initialisierung gesetzt.

Vorwärtspropagation (Forward Propagation):

- Die Eingabedaten werden durch das Netz geleitet, und die Ausgaben jeder Schicht werden berechnet, bis die endgültige Ausgabe in der Ausgabeschicht vorliegt.

Verlustfunktion (Loss Function):

- Eine Verlustfunktion misst, wie gut oder schlecht die Ausgabe des Netzes im Vergleich zu den tatsächlichen Zielwerten ist. Häufig verwendete Verlustfunktionen sind Mean Squared Error (MSE) für Regression und Cross-Entropy für Klassifikation.

Rückwärtspropagation (Backpropagation):

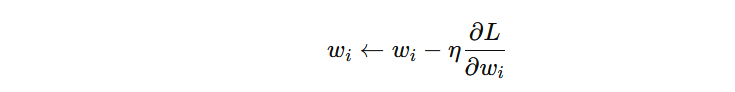

- Ein Algorithmus, der die Gradienten der Verlustfunktion in Bezug auf die Gewichte berechnet und diese verwendet, um die Gewichte anzupassen. Dies geschieht durch den Gradientenabstieg:

Hierbei ist die Lernrate und der Gradient der Verlustfunktion .

Optimierung:

- Algorithmen wie Stochastic Gradient Descent (SGD), Adam oder RMSprop werden verwendet, um die Gewichte iterativ zu aktualisieren und die Verlustfunktion zu minimieren.

Last modified: Tuesday, 4 June 2024, 6:08 AM